윈도우 환경에 openclaw 설치하기 (ollama 사용)

0) 큰 그림 (구성)

-

Windows: WSL2(Ubuntu) 설치

-

WSL2(Ubuntu): OpenClaw CLI + Gateway 설치/상시 실행

-

WSL2(Ubuntu): Ollama 설치 + 모델 pull

-

OpenClaw: Ollama를 기본 모델로 설정

-

OpenClaw: Telegram 봇 토큰 연결 + DM pairing 승인

Windows 네이티브 설치는 “비권장/문제 많음”이라 OpenClaw는 WSL2에서 돌리는 방식이 권장입니다.

1) WSL2(Ubuntu) 설치 (Windows PowerShell 관리자)

-

PowerShell(관리자) 실행 후:

wsl --install

# 또는 배포판 지정

wsl --list --online

wsl --install -d Ubuntu-24.04

-

재부팅 요구가 뜨면 재부팅

(이 단계는 OpenClaw Windows(WSL2) 공식 가이드에 그대로 있습니다.)

2) WSL2에서 systemd 활성화 (Gateway 서비스 설치에 필요)

OpenClaw Gateway를 “서비스(daemon)”로 설치하려면 WSL2에서 systemd 활성화가 필요합니다.

-

Ubuntu(WSL) 터미널에서:

sudo tee /etc/wsl.conf >/dev/null <<'EOF'

[boot]

systemd=true

EOF

-

PowerShell(관리자) 에서 WSL 재시작:

wsl --shutdown

-

다시 Ubuntu(WSL) 열고 확인:

systemctl --user status

3) WSL2(Ubuntu)에 Node.js 22+ 설치 (필수)

OpenClaw는 **Node 22+**를 요구합니다.

Ubuntu에서 보편적인 설치 예시(권장 패턴):

sudo apt-get update

sudo apt-get install -y curl ca-certificates

curl -fsSL https://deb.nodesource.com/setup_22.x | sudo -E bash -

sudo apt-get install -y nodejs

node -v

npm -v

4) OpenClaw 설치 (WSL2 안에서)

방법 A) 공식 설치 스크립트(권장)

curl -fsSL https://openclaw.ai/install.sh | bash

방법 B) npm 전역 설치(대안)

npm install -g openclaw@latest

5) 온보딩 + Gateway 서비스 설치

WSL2(Ubuntu)에서:

openclaw onboard --install-daemon

설치 후 상태 확인(문서 권장 체크):

openclaw doctor

openclaw status

openclaw health

openclaw dashboard

6) Ollama 설치 + 로컬 모델 내려받기 (WSL2 안에서 추천)

OpenClaw는 Ollama의 OpenAI 호환 API로 연동하며, 가장 단순한 조합은 Ollama도 WSL2 안에 같이 설치하는 것입니다(네트워크 꼬임 방지).

6-1) Ollama 설치 (Linux/WSL2)

curl -fsSL https://ollama.com/install.sh | sh

6-2) 모델 pull (예시)

OpenClaw Ollama 문서 예시:

ollama pull llama3.3

# 또는

ollama pull qwen2.5-coder:32b

# 또는

ollama pull deepseek-r1:32b

(추가로, Ollama 쪽 “OpenClaw 추천 모델” 목록도 참고 가능)

7) OpenClaw가 Ollama를 기본 모델로 쓰게 설정

OpenClaw는 OLLAMA_API_KEY를 아무 값으로라도 설정하면(실키가 필요 없지만 “사용하겠다”는 opt-in) 로컬 Ollama를 감지/연동합니다.

7-1) Ollama 사용 opt-in

export OLLAMA_API_KEY="ollama-local"

영구 적용하려면(WSL bash 기준):

echo 'export OLLAMA_API_KEY="ollama-local"' >> ~/.bashrc

source ~/.bashrc

7-2) 기본 모델을 Ollama로 지정

가장 직관적인 방법은 설정 파일(~/.openclaw/openclaw.json)에 아래처럼 넣는 것입니다.

예시(핵심만):

{

"agents": {

"defaults": {

"model": { "primary": "ollama/llama3.3" }

}

}

}

모델 인식 확인:

openclaw models list

(그리고 필요하면 openclaw doctor로 점검)

참고: OpenClaw는 맥락 창이 큰 모델을 권장(예: 64k 토큰 이상)합니다. 다만 로컬 모델은 CPU만으로도 되지만 속도는 모델 크기에 크게 좌우됩니다.

8) Telegram 채널(봇) 연결: ncue_bot

OpenClaw의 Telegram은 Bot API 기반이며, 가장 쉬운 연결은 “봇 토큰”을 설정하는 것입니다.

8-1) Telegram에서 봇 만들기 (BotFather)

-

Telegram에서 BotFather 와 대화 시작

-

/newbot실행 → 이름/유저네임 설정 (유저네임은...bot로 끝나야 함.ncue_bot은 규칙에 맞습니다) -

발급되는 Bot Token 복사(유출 주의)

8-2) OpenClaw에 Telegram 토큰 설정

방법 A: 환경변수로 설정(간단)

export TELEGRAM_BOT_TOKEN="123:abc"

방법 B: openclaw.json에 설정(권장 / 명시적)

{

"channels": {

"telegram": {

"enabled": true,

"botToken": "123:abc",

"dmPolicy": "pairing"

}

}

}

문서 기준으로 DM은 기본이 “pairing(승인 코드)” 흐름이라, 처음 보는 사용자는 승인 전까지 처리가 안 됩니다.

8-3) Gateway 재시작/상태 확인

openclaw status

openclaw health

(설정 변경 시 자동 리로드되는 경우도 있지만, 상태 체크는 꼭 해주세요.)

8-4) Telegram에서 @ncue_bot 에게 DM 보내기 → pairing 승인

-

Telegram에서 @ncue_bot 열고 아무 메시지 전송

-

봇이 **pairing 코드(8자리)**를 주면, WSL에서 승인:

openclaw pairing list telegram

openclaw pairing approve telegram <CODE>

pairing/allowlist 상태 파일은 ~/.openclaw/credentials/ 아래에 저장되니 민감정보로 취급하세요.

9) “잘 됐는지” 최소 점검 체크리스트

WSL(Ubuntu)에서 아래가 모두 통과하면 연결 완료입니다.

-

OpenClaw 서비스/게이트웨이:

openclaw doctor

openclaw status

openclaw health

-

Ollama 응답:

ollama list

curl http://localhost:11434/api/tags

-

OpenClaw에서 Ollama 모델 보임:

openclaw models list

-

Telegram DM에서 응답 + pairing 승인 완료:

openclaw pairing list telegram

10) 자주 막히는 포인트 (빠른 해결)

-

Telegram에 메시지 보내도 무응답:

dmPolicy: "pairing"이면 pairing 승인 전이라 정상입니다.openclaw pairing list telegram부터 확인하세요. -

Ollama 모델이 OpenClaw에 안 뜸:

OLLAMA_API_KEY설정이 빠졌거나, OpenClaw가 접근 가능한 Ollama가 안 떠 있는 경우가 많습니다(위의curl /api/tags로 확인). -

WSL에서 데몬 설치가 안 됨: systemd 미활성일 가능성이 큽니다(2단계 다시 점검).

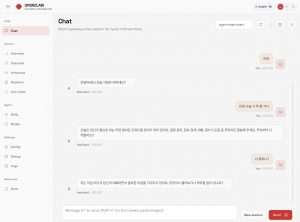

설치 성공 화면

25phdream

says:Okay, 25phdream, this is my new go to. Lots of options and fun to play. Worth a shot if you are looking for something different. 25phdream