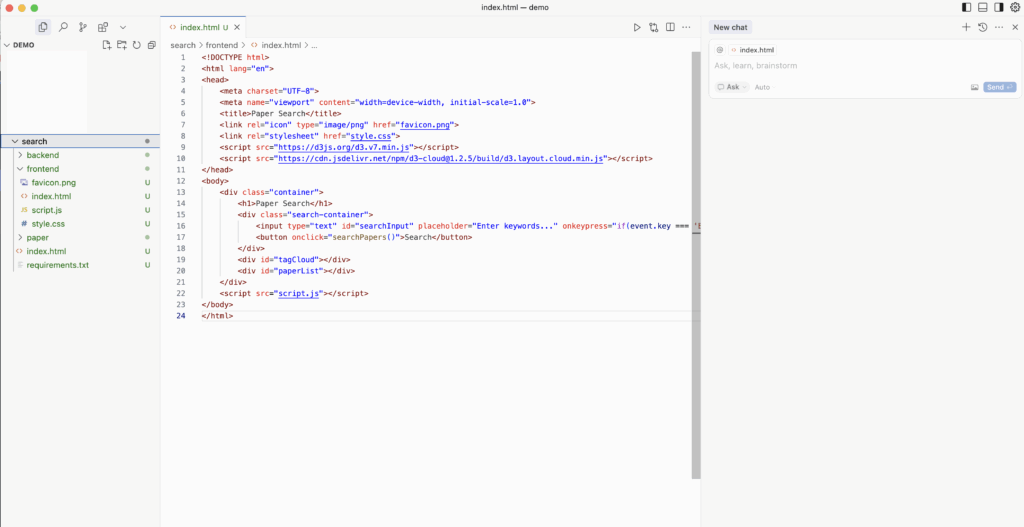

메타, ‘확산형 LLM’ 추론 능력 향상하는 강화학습 프레임워크 공개

메타에서 개발한 새로운 프레임워크 ‘d1’에 대한 내용입니다.

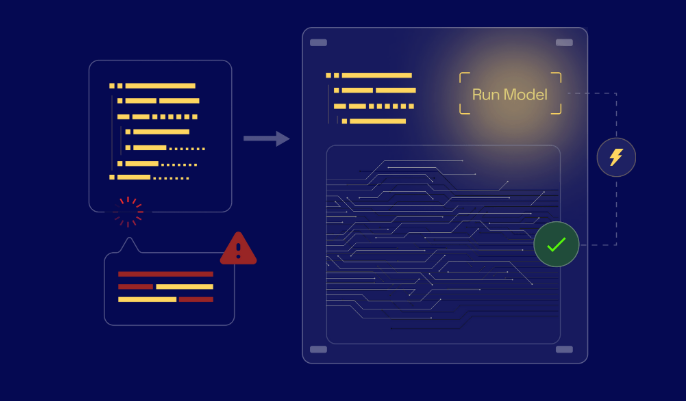

- d1은 트랜스포머와 확산 아키텍처를 결합한 dLLM(확산 기반 대형언어모델)의 추론 능력을 강화학습을 통해 향상시키는 것을 목표로 합니다.

- d1 프레임워크는 사전 훈련된 dLLM을 지도 미세 조정(SFT)과 강화 학습(RL)로 훈련하여 기존 트랜스포머 모델보다 뛰어난 추론 능력을 발휘합니다.

- ‘디퓨-GRPO’라는 새로운 알고리즘과 ‘무작위 프롬프트 마스킹’ 기법을 통해 학습 효율성을 높였습니다.

빠른 작업 처리와 심도 있는 추론 능력을 동시에 제공하여, 엔터프라이즈 워크로드를 위한 다양한 에이전트 지원 및 일상적인 디지털 워크플로우 자동화에 기여할 것으로 기대됩니다.

스테이지파이브, LLM 기반 AI 고객센터 런칭

스테이지파이브는 자체 고객센터 데이터를 활용하여 LLM 기반 AI 고객센터를 국내 통신사업자 최초로 공식 출시했습니다.

- AI 고객센터는 24시간 실시간 맞춤형 답변을 제공하며, 비정형 질문에도 정확하게 대응하여 고객 만족도를 높이고 상담 인력의 부담을 줄여줍니다.

- AI 상담 도입 후 온라인 상담 처리 건수가 117% 증가했으며, 이 중 약 40%를 AI가 처리하고 있습니다.

- 스테이지파이브는 AI 고객센터를 시작으로 AI 고객 케어 및 AI 세일즈로 AI 에이전트의 확장을 추진 중입니다.

- 핀다이렉트 플랫폼을 AI 플랫폼으로 고도화하여 고객 맞춤형 솔루션을 제공하고 비즈니스 효율성을 극대화할 계획입니다.

스테이지파이브의 AI 고객센터 도입은 고객 서비스 분야에서 AI 기술의 가능성을 보여주는 좋은 사례입니다. 특히, 온라인 상담 처리 건수가 크게 증가하고, AI가 상당 부분을 처리하는 것을 보면 효율성 증대 효과가 뚜렷한 것으로 보입니다. 앞으로 AI 고객 케어 및 AI 세일즈 등 AI 에이전트의 확장을 통해 더욱 다양한 분야에서 고객 경험을 향상시킬 수 있을 것으로 기대됩니다.

히츠 “AI 신약개발 플랫폼 ‘하이퍼랩 2.0’ 신약개발 시간·비용 획기적 절감”

HITS(히츠) 회사의 AI 기반 신약 개발 플랫폼 ‘Hyper Lab 2.0’과 신약 개발에 필요한 시간과 비용을 획기적으로 줄일 수 있는 잠재력에 대해 설명합니다.

- Hyper Lab 2.0은 AI를 활용하여 11조 개의 화합물 후보를 가상으로 스크리닝하고 합성하며, 48시간 이내에 유망한 약물 후보를 식별할 수 있습니다.

- 사용자 친화적인 인터페이스를 제공하며, 도킹, 가상 스크리닝, 결합 예측 및 속성 분석과 같은 다양한 기능을 단일 플랫폼에 통합합니다.

- 이 플랫폼은 MD 앤더슨 암센터를 포함한 주요 기관의 관심을 끌었으며, MD 앤더슨 암센터는 Hyper Lab을 사용하여 새로운 후보 물질을 성공적으로 식별했습니다.

- HITS는 전 세계 326개 이상의 제약 회사 및 연구 기관과 협력했으며 103억 원의 자금을 확보했습니다.

- 회사는 2026년에서 2027년 사이에 상장을 계획하고 있습니다.

AI 기반 신약 개발 플랫폼은 신약 개발 프로세스를 가속화하고 비용을 절감하는 데 중요한 역할을 할 수 있습니다. Hyper Lab 2.0과 같은 플랫폼은 제약 회사와 연구 기관이 더 효율적으로 새로운 약물 후보를 식별하고 개발하는 데 도움이 될 수 있습니다. HITS의 성공적인 협력 및 자금 확보는 AI 기반 신약 개발 분야의 성장 가능성을 보여줍니다.

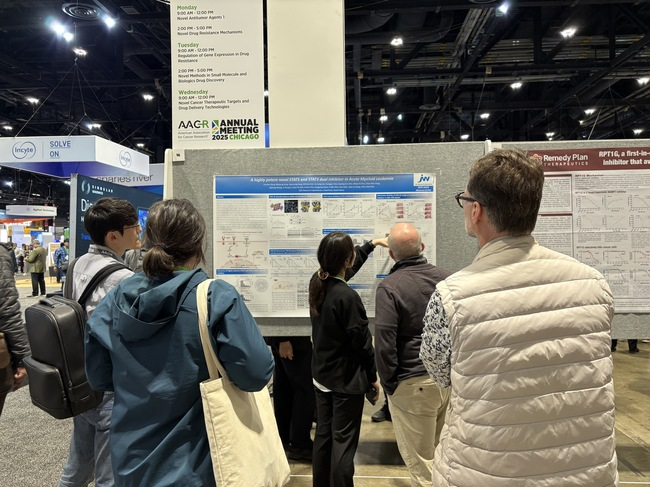

JW중외제약 C&C신약연구소, AI 활용 AML 치료제 ‘CNC-01’ 글로벌 주목…美서 비임상 결과 공개

JW중외제약 C&C신약연구소가 개발 중인 AI 기반 급성 골수성 백혈병(AML) 치료제 ‘CNC-01’이 글로벌 시장에서 주목받고 있다는 내용을 담고 있습니다

- CNC-01의 비임상 결과는 미국암연구협회(AACR) 2025에서 발표되었으며, 기존 치료제에 내성을 보이는 AML 모델에서 종양 성장을 억제하고 BCL-2 억제제와 병용 시 효과가 향상되는 것을 보여주었습니다.

AI 기반 신약 개발 플랫폼 ‘JWave’를 활용하여 개발되었다는 점에서, AI 기술이 제약 분야의 혁신을 가속화할 수 있음을 시사합니다.

기존 치료제 내성 문제를 해결할 수 있는 새로운 작용 기전을 가진 약물이라는 점에서, AML 치료 분야에 큰 기여를 할 수 있을 것으로 기대됩니다.

글로벌 AML 치료제 시장 규모가 상당하다는 점을 감안할 때, CNC-01의 성공적인 개발 및 상업화는 JW중외제약의 성장에 중요한 역할을 할 수 있을 것입니다.

의약품, AI 생태계 조성 방안 논의

제약 산업에서 인공지능(AI) 생태계를 구축하기 위한 방안에 대해 다루고 있습니다.

- 식품의약품안전처(식약처)는 ㈜종근당을 방문하여 AI 기반 생산 현장을 시찰하고 AI 생태계 조성 전략을 논의했습니다.

- ㈜종근당은 AI, 빅데이터 및 자동화 시스템을 기반으로 제품 품질을 향상시키기 위한 통합 가상 플랫폼을 구축하고 있습니다.

- 식약처는 AI 기술 적용이 제품 품질을 더욱 향상시킬 것으로 기대하고 있습니다.

- 제약업계와의 회의에서 AI를 활용한 의약품 개발 및 품질 관리 현황, AI 활용 의약품 승인 심사 기준에 대한 규제 지원 계획, AI 생태계 조성을 위한 협력 방안 등이 논의되었습니다.

- 업계는 AI 기술을 활용하여 안전하고 신속하게 효과적인 의약품을 개발할 수 있도록 규제 지원 및 협력을 요청했습니다.

AI 기술은 제약 산업의 혁신을 가속화할 수 있는 잠재력이 큽니다. 특히 의약품 개발 기간 단축, 품질 향상, 생산성 증대 등에 기여할 수 있을 것으로 기대됩니다.

식약처의 적극적인 지원과 업계의 노력이 조화를 이룬다면, 한국 제약 산업이 AI 기술을 선도하는 국가로 발돋움할 수 있을 것입니다.

AI 기술 도입에는 데이터 보안, 윤리적 문제 등 해결해야 할 과제도 존재합니다. 이러한 문제들을 슬기롭게 해결해 나가는 것이 중요합니다.

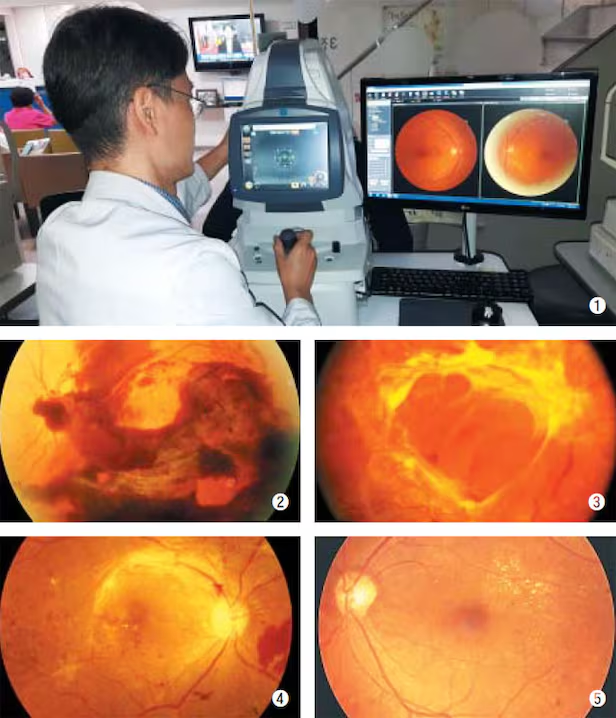

대웅제약, ‘디지털 전환 가속’ AI 의료·신약 개발 아우른다

- 대웅제약은 AI 기반 디지털 헬스케어 및 신약 개발을 가속화하고 있습니다. ‘Whiskey’ (실명 진단) 및 ‘Think’ (스마트 환자 모니터링)와 같은 AI 기반 솔루션의 공급을 확대하고 있습니다.

- 고려대학교 안암병원과 협력하여 AI 신약 개발 역량을 강화하고 있습니다.

- AI 기반 진단 도구를 활용한 디지털 헬스케어 기반 건강 검진을 실시하고 있습니다 (예: 안질환 진단, 근육 손실 평가).

- ‘Think’는 웨어러블 바이오센서와 AI를 사용하여 환자의 활력 징후를 실시간으로 분석하고 전송하여 초기 위험 상황 감지에 도움을 주는 원격 심박수 모니터링에 대한 보험 적용을 받았습니다.

- AI 및 디지털 헬스케어 시장은 빠르게 성장하고 있으며, 2030년에는 시장 규모가 1,817억 9천만 달러에 달하고 연평균 성장률은 41.8%에 이를 것으로 예상됩니다.

대웅제약은 AI 기술을 활용하여 헬스케어 분야에서 혁신을 주도하고 있는 것으로 보입니다. 특히, AI 기반 진단 솔루션 및 신약 개발은 환자 치료 및 건강 관리에 큰 영향을 미칠 수 있을 것으로 예상됩니다. 또한, 디지털 헬스케어 시장의 높은 성장률은 이 분야의 잠재력을 보여줍니다.